Desconfortável quando hoje, a caminho de um compromisso, desafiou o Waze e chegou mais tarde do que o tempo estimado na app? E quando, daqui a uns meses, no nosso telefone estiver disponível uma nova versão do ChatGPT com conhecimentos ao nível de um doutorado… iremos todos obedientemente seguir os seus conselhos?

Em 1961, o nazi Adolf Eichmann, no julgamento que teve lugar em Jerusalém, apresentou uma defesa tão simples como “eu só seguia ordens”.

Três meses depois, o psicólogo Stanley Milgram conduziu uma experiência onde pretendia perceber se Eichmann e os seus milhões de cúmplices no Holocausto apenas cumpriam ordens ou foram também cúmplices. Na experiência, era dito aos participantes que o objeto do estudo era testar se o castigo físico era útil na aprendizagem. O participante era o “professor” e, a cada resposta errada, aumentava a voltagem do choque elétrico. Se o “professor” hesitava, o “responsável” da experiência repetia algo como: deve continuar, a experiência assim o obriga e esclarecia que a responsabilidade pelo “aluno” era sua. Na verdade, não havia choques e o aluno era um ator (um homem de 50 anos). Os colegas de Milgram antecipavam que não mais de 2% a 3% dos participantes no teste aceitariam a ordem de infligir sofrimento a outro ser humano. O resultado foi desconcertante. Ainda que com manifestações de grande stresse, 65% dos participantes pressionaram o botão “perigo”. A experiência foi posteriormente repetida em diferentes cenários e variantes, mas os resultados mantiveram-se estáveis (documentário disponível no YouTube).

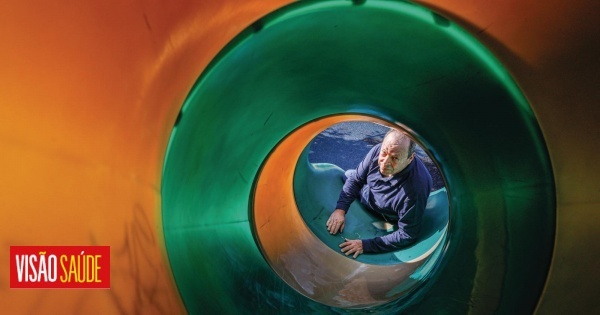

E se a maioria está disposta a cumprir ordens de quem entende que tem autoridade e é responsável, ainda que violem os seus valores morais, como será quando nos próximos dois anos a Inteligência Artificial se tornar omnipresente? Iremos, também nós, reconhecendo a superinteligência do ChatGPT, segui-lo cegamente?

O cenário parece distópico. A maioria de nós utiliza o ChatGPT de forma “básica”. Mas será assim tão longínquo o momento em que abandonamos a nossa autodeterminação a uma forma de inteligência alienígena, como a categoriza Yuval Harari no seu livro Nexus?

Na verdade, já o estamos a fazer e com algoritmos muito menos inteligentes. Nos Estados Unidos da América, desde 2016, vários tribunais utilizam algoritmos para “recomendar” uma pena ao juiz. Ora, sendo o algoritmo treinado em casos passados, não surpreende que as sentenças recomendadas para brancos e negros sejam profundamente diferentes (recorde-se que a população negra nos Estados Unidos da América é de apenas 12%, mas os negros representam 37% da população prisional). Na decisão de um pedido de crédito ou do valor do seguro automóvel, os algoritmos já imperam, mas se pedir que lhe expliquem porque foi recusado o seu pedido ou cobrado um determinado valor, a resposta será provavelmente evasiva. O funcionário não compreende como funciona o algoritmo.

No ano passado, foi publicado o Regulamento Europeu Inteligência Artificial, mas a sua aplicação efetiva está por acontecer. E sendo certo que nada irá moderar o ritmo do desenvolvimento tecnológico, serão as regras existentes suficientes? Depende da sua aplicação. Do que qualificamos como recomendações, ordens e manipulação. Da forma como em cada organização a Inteligência Artificial for utilizada e os princípios éticos a que estará sujeita.

Esta não é uma questão a ser resolvida entre Ursula von der Leyen, Trump e Mark Zuckerberg. É nossa, individualmente e das entidades nas quais trabalhamos e em cujos processos de decisão participamos.

OUTROS ARTIGOS DESTE AUTOR

+ Enfrentar o algoritmo editor

Os textos nesta secção refletem a opinião pessoal dos autores. Não representam a VISÃO nem espelham o seu posicionamento editorial.