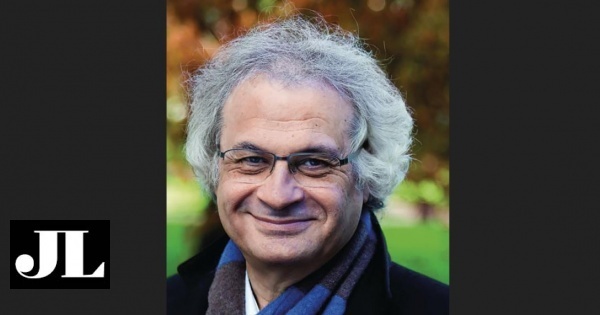

A Inteligência Artificial (IA) assusta, mas só a quem não a conhece. Na verdade, pode ser uma ferramenta bastante útil para combater o preconceito e a discriminação, num mundo onde, cada vez mais, o que é dito está sob escrutínio. Alon Lavie estuda a IA há 30 anos, pertence ao departamento de Inteligência Artificial aplicada à linguagem, no Carnegie Mellon, onde dá aulas. Ocupa ainda o cargo de vice-presidente de Tecnologias Linguísticas da portuguesa Unbabel, uma startup que encontrou na tradução simultânea espaço livre para crescer e conquistar o mundo. À VISÃO, o especialista falou sobre a importância desta tecnologia na tradução e na relação com os outros.

A IA vai matar-nos, e seremos todos dominados por robôs, tal como muitos acreditam?

[Risos.] Acho que as pessoas olham para a IA como uma caixa negra e temem o que está lá dentro porque não a conhecem. De facto, tudo o que é possível fazer parece muito extraordinário, mas é muito mais extraordinário visto de fora. Eu sei como estes modelos são criados, como são construídos, e sei também que não são tão inteligentes quanto parecem. Por exemplo, eu gosto de ler as traduções que os nossos sistemas fazem e vejo imensos exemplos que me levam a olhar para ambas as direções. Às vezes, paro numa frase e digo: ‘Uau! Que tradução perfeita! Como é possível que este sistema estúpido tenha conseguido fazer tão bem esta tradução?’ Mas, na maior parte do tempo, o que vejo são erros mesmo estúpidos…

Fica surpreendido?

Não, porque o que usamos, na verdade, são ainda algoritmos muito simples ou muito ingénuos, se pudermos chamá-los assim. Eles não estão a entender o mesmo significado do que nós, quando estamos aqui a falar, estamos a dizer. São apenas uma representação apreendida de palavras. Ou seja: há uma relação entre as palavras e o que elas significam, mas não há aqui um entendimento superinteligente escondido. Os algoritmos não estão a pensar nisso [risos] nem estão a aplicar um pensamento lógico e complexo sobre o que estão a representar. Ainda estamos mesmo muito longe de um cenário em que a IA conquista o mundo! Mas, talvez, continuemos a ser surpreendidos, claro. Olhando para dentro das caixas negras, acho que vamos ver a IA a fazer coisas muito inteligentes.

Se tivesse de adivinhar qual seria a maior evolução nos próximos cinco anos, qual seria?

Creio que vai haver uma aplicação muito mais alargada e genérica de modelos de IA nos negócios e nas empresas, uma adoção em massa da IA em quase todas as áreas: medicina, finanças, e-commerce, manufatura. Praticamente todas as grandes áreas de economia vão adotar IA nos próximos cinco anos. Acho que vamos assistir a melhorias sustentadas dos modelos de IA – claro que posso ser surpreendido com uma descoberta fascinante, mas, por acaso, não acredito que o paradigma vá mudar dramaticamente, como quando começámos a usá-la há uns cinco anos. Mas isso é a minha bola de cristal! [Risos.]

Como podemos convencer as pessoas a não terem medo da IA?

Acho que o benefício social que vem deste tipo de avanço tecnológico é imenso, portanto temos de enfatizar este aspeto. Se a IA nos ajudar a acelerar o processo de descoberta de vacinas para um novo vírus e se reduzir o tempo, de um ano para seis meses, para se ter uma vacina – e é muito plausível que a IA ajude a fazê-lo num futuro próximo –, estamos a falar de salvar, potencialmente, centenas de milhares de vidas, certo? Se a IA nos ajudar a fazer os diagnósticos certos, na medicina, isso vai salvar vidas. Se ajudar as pessoas a encontrar os produtos exatos que querem, no e-commerce, isso vai facilitar-lhes imenso as vidas; se nos ajudar a traduzir corretamente as línguas que existem e se permitir que falemos com uma pessoa de qualquer parte do mundo, quando quisermos e de forma gratuita… isso é uma contribuição imensa para a vida das pessoas.

Mas há riscos?

Há, mas não há razões para ter medo. Acho que esse medo tem estado muito associado ao desconhecimento. Penso que as grandes tecnológicas que têm desenvolvido este tipo de tecnologia, que têm feito investimentos alargados e colocado estes recursos a funcionar, têm uma responsabilidade imensa nisto.

O que ainda o entusiasma?

Eu queria trabalhar em algo que pudesse mesmo ter impacto na Humanidade, na vida das pessoas, em geral. E acho que o processamento de linguagem pode fazê-lo! Trabalho nisto há 20 ou 25 anos, e fizemos percursos incríveis, mas continuamos tão longe do que pode ser alcançado. Por exemplo, nos últimos cinco anos, demos passos significativos no desenvolvimento destas tecnologias, mas eu diria que agora estou no ponto que me fez querer entrar para este campo de investigação [risos]. Portanto, há sempre muito mais a descobrir!

Falemos, concretamente, da utilização da Inteligência Artificial na linguagem e na comunicação. A IA é preconceituosa?

Primeiro, o conceito é muito simples: fundamentalmente, todos os sistemas de IA aprendem de dados. Aprendem relações muito complexas que estão escondidas nos dados. Portanto, coisas que estão apenas latentes, escondidas mesmo dentro de um leque muito alargado de informação, vão impactar no que estes sistemas aprendem.

O que usamos, na verdade, são ainda algoritmos muito simples ou muito ingénuos, se pudermos chamá-los assim. Eles não estão a entender o significado do que nós, quando estamos aqui a falar, estamos a dizer”

Então, podemos dizer que sim?

Primeiro, temos de esclarecer uma coisa: em muitos casos, as pessoas começaram a acumular esta informação [que usamos para criar conceitos ou preconceitos] há muito tempo. Os sistemas não estão a aprender de uma informação que tem apenas uns meses. Eles vão buscar informação muito antiga. Portanto, é fácil entender que, por exemplo, a informação histórica tenha, contida nela própria, alguns preconceitos, nomeadamente muita informação relacionada com a discriminação de género, questões de racismo… coisas a que temos dado mais atenção nos últimos cinco ou dez anos. Tudo estava lá nessa informação anterior. E, sim, a informação mais recente tem menos preconceitos, quando pensamos nesses assuntos específicos. Porém, ainda há todo um histórico de informação anterior que tem preconceitos inerentes.

Por exemplo, as questões de género?

Esse caso é muito óbvio. Falando concretamente da Unbabel. Na minha opinião, há muitas outras aplicações em que essas questões têm um impacto muito mais dramático, mas, às vezes, na tradução sofremos um bocadinho com isso. De qualquer forma, aqui focamo-nos muito na tradução de comunicação, pelo que, mesmo quando existem erros nas traduções que fazemos – assumir que um homem é uma mulher ou vice-versa, ou quando traduzimos incorretamente porque, quando nos dirigimos a alguém que é médico ou engenheiro, assumimos que se trata de homens [risos]… –, a verdade é que isso pode ser estranho e ofensivo, mas, como é um contexto de comunicação e como os clientes sabem que estamos a usar uma máquina, não atinge proporções tão graves.

Mas…

Mas, por exemplo, se estivermos a falar de uma aplicação que esteja a selecionar alguém para um emprego e se o sistema excluir as candidatas porque está a fazer um matching entre currículo e características e se, devido à informação histórica em que se está a basear, considerar que as mulheres não são adequadas àquela profissão – mesmo que isso não esteja escrito em lugar nenhum –, isso é um grande problema! E é algo muito mais difícil de corrigir. Na verdade, acho que até temos sorte na Unbabel. Temos efetivamente algum preconceito, e eu acho isso muito interessante, porque, tendo em conta o feedback que recebemos dos nossos clientes, descobrimos, muitas vezes, preconceitos de que não nos tínhamos apercebido ou que não tinham despertado a nossa atenção!

O que fazem nesses casos?

Primeiro, tentamos resolver a informação, ou seja os dados que estão na origem do processo de aprendizagem. No fundo, procuramos fazer um contraponto a esses dados, tentando equilibrar a informação para conseguirmos ter um resultado diferente e mais equilibrado. Na tradução, isso até é mais fácil de se fazer do que em outros setores…

Porquê?

O cenário em que operamos é um em que desenvolvemos estes sistemas de tradução, e os nossos clientes são, por seu lado, organizações de apoio ao cliente de empresas multinacionais. Portanto, os clientes dão-nos efetivamente feedback. Mas é importante lembrar que, em muitos casos, nós entregamos uma tradução automática que é editada por pessoas bilingues e, de facto, a verdade é que ter esses olhos humanos [risos] permite-nos apanhar vários erros que são resultado do preconceito. Agora, temos imensos erros que são apenas o que chamo “erros estúpidos”: palavras que não se usam naquela língua ou um termo errado… Mesmo nos casos em que usamos Unbabel em live chats, o output é o resultado da machine translation direta, que depois editamos offline. Percorremos uma série de informação para tentar resolver erros, sempre que temos a indicação de que, em episódios específicos, a qualidade não foi boa.

Quais têm sido os maiores desafios nesta área?

Duas coisas com as quais estamos a lidar e nas quais acho que estamos a fazer progressos: na análise de modelos de IA e no seu treino. Especializamos os modelos, estamos sempre a (re)treiná-los, para serem, no fundo, sempre melhores. Mas medir como esses modelos estão a evoluir é muito difícil, porque a linguagem é algo muito flexível, não é? É volátil e evolui. Tomemos como exemplo os benchmark tests: nunca há apenas uma resposta correta quando estamos a traduzir uma frase. Então, torna-se muito difícil ter essas fasquias bem definidas e essa avaliação totalmente correta. Às vezes, fazemos alterações muito subtis a cada modelo.

Mas como se ensina, por exemplo, cultura?

Tudo o que está relacionado com cultura e estilo é muito importante! Eu também gosto de pensar nisto como preconceito. Por exemplo, descobri que, em algumas culturas e línguas com as quais estamos a trabalhar, é muito importante gerar linguagem num determinado nível de educação e formalidade, porque, na verdade, há línguas, casos, produtos em que as pessoas querem ser muito formais e, noutros casos, em que preferem ser muito informais. O japonês talvez seja um bom exemplo: as pessoas são, tradicionalmente, muito formais, mas o inglês, sobretudo num contexto de comunicação, é bastante informal. Então, os asiáticos que falam inglês, muitas vezes, geram uma linguagem muito informal. Descobrimos ainda que, em japonês, isto é algo que realmente ofende alguns clientes. Nós estávamos, sem intenção, a ofender as pessoas!

E como se resolvem estas subtilezas?

Analisamos parte dos discursos dos clientes em cada língua e separamos os dados consoante o nível de formalidade. Por exemplo: esta informação é representativa de linguagem formal, esta é representativa de linguagem informal; depois, quando tivermos uma quantidade razoável de informação nos vários níveis de formalidade, podemos voltar a treinar o sistema, para que ele aprenda estas subtilezas.

E nós também podemos aprender com a IA neste caso concreto dos preconceitos?

Sim, podemos. É possível criar sistemas de IA que detetem preconceitos usados por humanos e, pelo menos, apontá-los, mostrar que uma pessoa está a usar uma linguagem preconceituosa. O que se faz depois, isso não sei [risos]. Mas, sim, é possível fazê-lo e há já atividade nesse sentido. O que é sabido é que a IA é utilizada nomeadamente para detetar alguns sentimentos. Já é usada para perceber se uma pessoa está zangada, se é hostil, se está feliz. Sim, podemos usar a IA para coisas relacionadas com sentimentos, com emoções… Então, porque não usá-la para encontrar o preconceito?