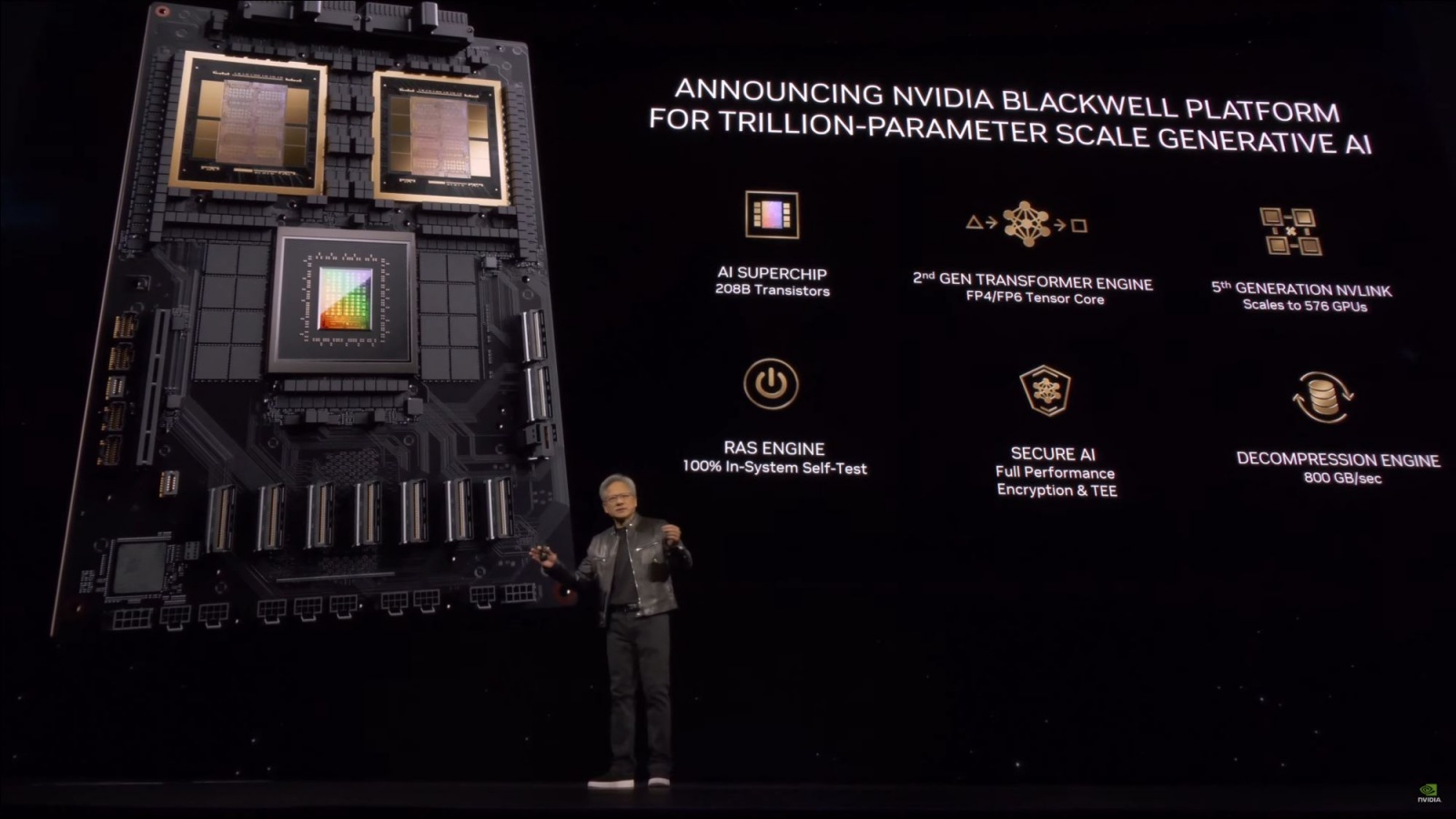

A Nvidia quer continuar a capitalizar com a área da Inteligência Artificial (IA) e depois dos chips H100 se terem tornado os preferidos da comunidade para tarefas de IA, a empresa mostra agora o seu chip gráfico mais poderoso de sempre: a GPU (unidade de processamento gráfica) Blackwell B200, é a nova referência do segmento, e vem acompanhada do ‘superchip’ GB200.

Sobre as principais características de cada componente, a Nvidia destaca que a B200 oferece até 20 petaflops de capacidade de processamento a partir dos 208 mil milhões de transístores e que o GB200 integra uma CPU Grace e consegue 30 vezes mais desempenho para os grandes modelos de linguagem (LLM), ao mesmo tempo que pode consumir até 25 vezes menos energia do que os H100.

Para explicar melhor os cálculos e mostrar o benefício, a Nvidia contou que para treinar um modelo de 1,8 biliões de parâmetros precisaria de oito mil GPU Hopper e 15 megawatts de energia, enquanto agora consegue o mesmo com duas mil GPU Blackwell e apenas quatro megawatts. No teste padrão do GPT-3 com 175 mil milhões de parâmetros, o GB200 oferece sete vezes o desempenho do H100 e é quatro vezes mais rápido.

A Nvidia está a apostar que o mercado vai ter interesse nestas soluções e está a disponibilizá-las integradas em grandes sistemas, como o GB200 NVL72, com 36 CPU e 72 GPU numa rack com arrefecimento líquido e capaz de 720 petaflos de desempenho em treino de IA ou 1400 petaflops (ou seja, 1,4 exaflops) de inferência, com mais de cinco mil cabos individuais no interior. Segundo o The Verge, cada rack destas consegue suportar um modelo de até 27 biliões de parâmetros e o GPT-4 (o modelo de referência da OpenAI, responsável pelo ChatGPT) terá cerca de 1,7 biliões destes.

Amazon, Google, Microsoft e Oracle já planeiam utilizar estes sistemas para as suas soluções de serviços na cloud, embora não se conheçam para já as quantidades encomendadas.