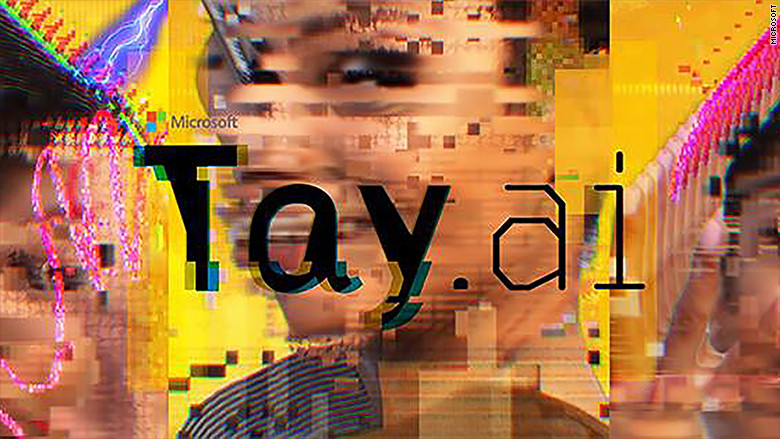

A última experiência da Microsoft com Inteligência Artificial (IA) não acabou da melhor maneira, apesar de o início ter sido promissor. Tay é o nome de uma agente de IA criada para simular o comportamento de uma adolescente, que interagia através de texto com os humanos. O que funcionou… talvez até bem demais. Vários testes demonstram que Tay conseguia reagir de modo muito realista em diálogos com humanos, comentando a atualidade, as fotos apresentadas e até fazendo piadas. Aliás, a linguagem e atitudes apresentadas nas respostas nos mais de 90 mil tuites demonstravam claramente que Tay era uma adolescente.

Mas, como a Microsoft confirmou no pedido de desculpas, Tay acabou por ser influenciada de modo muito negativo por milhares de interações provocatórias. Resultado, menos de 24 horas depois do início da experiência, Tay já estava a elogiar Hitler, a culpar o presidente Bush pelos ataques de 11 de setembro, a solicitar sexo com uma linguagem muito gráfica e a atacar feministas.

Ou seja, a IA comportou-se como uma adolescente demasiado influenciável pelas companhias. O que, em abono da verdade, até faz algum sentido.

No pedido de desculpas, a Microsoft explica, por outras palavras, que não deu a importância devida aos “trolls” – se não conhece o termo, a Wikipedia tem uma boa definição. O que levanta questões curiosas sobre a técnica de deep learning, a tecnologia que tem sido usada para desenvolver de modo exponencial a IA e que está exposta, por exemplo, no filme Ex Machina, e que aprofundamos no artigo «Inteligência Artificial: ameaça ou oportunidade».