A Mars, fabricante mundial de chocolates, quis saber como a escolha da banda sonora de um anúncio podia ter impacto no público. A Audi, a BMW e a Volvo, entre outras marcas, quiseram perceber quais os fatores que tornam alguns anúncios de carros virais. Os spots publicitários da edição deste ano do Super Bowl viram a sua eficácia testada antes de serem apresentados nos intervalos da final do campeonato da principal liga de futebol americano. Todas estas empresas recorreram aos serviços da RealEyes, uma startup de Inteligência Artificial (IA) emocional, que usa reconhecimento facial para analisar o estado de espírito das pessoas, consoante o que estão a ver.

Fundada em 2007 por Mihkel Jäätma, 39 anos, nascido na Estónia, juntamente com o seu conterrâneo Martin Salo e Elnar Hajiyev, do Azerbaijão, a RealEyes queria, inicialmente, ensinar aos computadores como se sentem os humanos. Mais de uma década depois, criaram uma base de dados que consideram ser a mais rica e sofisticada do mundo – é composta por 420 milhões de frames de pessoas que autorizaram a captura da imagem da sua cara enquanto assistiam a vídeos. Esses momentos estão catalogados por sete tipos diferentes, segundo a lista de emoções básicas do psicólogo norte-americano Paul Ekman: alegria, desprezo, aversão, raiva, medo, tristeza e surpresa.

No verão do ano passado, a RealEyes observou as reações de quatro mil pessoas que passaram a pente fino 20 anúncios de várias marcas que haveriam de ser transmitidos na campanha do Natal seguinte. Entre todos, havia qualquer coisa de estranho com The Boy and The Piano, campanha dos grandes armazéns britânicos John Lewis. O público britânico não ficou empolgado com as partes em que Elton John participava. Só quando o cantor aparecia ao lado de uma criança surgia o sentimento positivo, pois o assunto passava a ser a família, em vez de a celebridade. No fim da análise, o anúncio conseguiu uma pontuação de 7,8 em 10, ficando em 12º lugar entre 20. Concluíram que o spot poderia ter tido um melhor resultado se não tivesse a participação de Elton John, ou se pelo menos fosse mais curto – dois minutos e vinte segundos só são vistos em televisão, não no online. “Neste momento, a Inteligência Artificial é como um cérebro muito inteligente e que sabe tudo, mas falta-lhe um coração. Queremos incorporar a compreensão emocional e a consciência”, assume Mihkel Jäätma.

Automatizar e massificar

Os grupos de discussão (focus groups) existem há décadas, basta lembrar o seu uso durante a II Guerra Mundial (1939-1945) para analisar a eficácia da propaganda e testar as reações às transmissões de rádio antinazis. Os estudos anteriormente feitos de modo manual – em que relatores tomavam notas sobre as reações das pessoas – tornam-se agora automatizados, passando a ser feitos de forma massificada, sem haver intervenção humana e acarretando todos os problemas inerentes à falta de privacidade.

Por cá, a startup portuguesa Viva Superstars criou um serviço interativo de televisão através da plataforma Magycal. Em 2018, na última edição de Secret Story, reality show da TVI em que 17 concorrentes estão fechados numa casa vigiada por câmaras e microfones, a aplicação oficial do programa desenvolvida pela Viva Superstars permitia medir a popularidade dos participantes a partir das reações dos internautas, fazendo com que os concorrentes tivessem mais ou menos benefícios dentro da casa. “São usadas duas tecnologias distintas: uma reconhece qual o concorrente que está a ser filmado; a outra pergunta às pessoas, através de interatividade na aplicação, se estão a gostar ou não do programa. As emoções positivas e negativas são atribuídas aos concorrentes analisados”, explica o líder, Eduardo Dias. “O próximo passo será tentar detetar automaticamente como o próprio concorrente está a sentir-se. Mas o mais interessante é mesmo saber a reação do telespectador perante o concorrente. Para já, decidimos fazer isso através de interatividade e não com o reconhecimento facial com emoções”, acrescenta. Analisar as emoções do telespectador tem problemas subjacentes. “Isso já é possível ser feito, mas achámos que poderia ser contraproducente estar a usar em permanência a câmara fotográfica dos telemóveis das pessoas, captando tudo o que estavam a fazer. Pode gerar uma desconfiança enorme.”

As duas câmaras existentes na famosa praça londrina Piccadilly Circus, por cima da loja da Gap, estão de olhos postos nos nossos olhos. Enquanto são projetados anúncios de publicidade nas telas gigantes, as câmaras, propriedade do Land Securities Group, conhecido por Landsec, analisam as reações. Ao identificarem uma cara, indo ao pormenor de registar se tem óculos ou barba, a tecnologia calcula a idade aproximada, o género e o estado de espírito, com base em detalhes, como um franzir de testa ou um sorriso. Graças à combinação destas informações, podem exibir publicidade que o público provavelmente achará relevante e interessante – quanto mais tempo olham na direção da câmara, logo do anúncio, mais denunciam o seu interesse. No comércio, a RealEyes também fez uma experiência com a Mothercare, marca especializada em maternidade e puericultura, em que constatou que os clientes recebidos à porta da loja com um sorriso tendencialmente gastavam mais dinheiro.

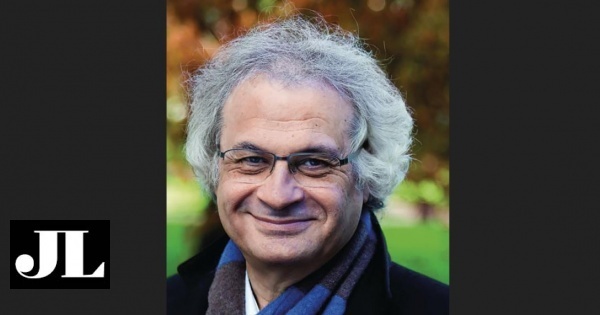

É através de algoritmos pré-programados que a tecnologia fica a saber o que significa cada franzir de sobrolho, arquear de sobrancelhas, morder de lábios ou rir com a boca toda. Em alguns softwares, a análise da orientação da cabeça e o nível de atenção, ou seja, a linguagem corporal, também são tidas em conta para informar acerca das emoções que prevalecem numa determinada situação, como descreve António Sacavém, coach e especialista em reconhecimento emocional.

“Uma das variações do medo é o chamado esgar de boca, em que esta se ‘rasga’ de orelha a orelha e os músculos do pescoço se contraem. É uma expressão que é bastante visível em situações de negociação. Uma variação da emoção raiva é visível através da descida das sobrancelhas e do arregalar dos olhos. A raiva é, geralmente, acompanhada de uma projeção do corpo, cabeça e pescoço para a frente, na direção do outro, e o peito pode estar erguido e inchado”, acrescenta António Sacavém.

Como fazem os gigantes

Há três anos, a Apple comprou a Emotient, startup de IA que lê emoções humanas a partir da análise de expressões faciais. O Facebook está a desenvolver ferramentas próprias baseadas em emoções. E, já este ano, em maio, a Amazon anunciou que tinha melhorado a sua assistente virtual Alexa, usando a IA para detetar emoções humanas. O medo é a oitava emoção que o Rekognition da Amazon consegue identificar com sucesso. O sistema consegue também reconhecer emoções como felicidade, tristeza, fúria, surpresa, nojo, calma ou confusão.

A par da Google, com uma plataforma mais direcionada para programadores, a Microsoft é provavelmente, na versão empresarial, a empresa com a aposta mais forte na IA. “Em termos de ‘Serviços Cognitivos’ temos a maior oferta no mundo. São serviços que não precisam de ser treinados e que já podem ser consumidos dentro de uma aplicação móvel ou num portal”, explica Manuel Dias, diretor da área técnica da Microsoft Portugal e vice-presidente da Associação Portuguesa de Data Science. Vamos a exemplos concretos: no “Reconhecimento de Imagem” incluem-se as montras inteligentes. Num shopping, uma loja que tenha autorização para fazer reconhecimento de imagem pode identificar o género, a idade e o estado de espírito do cliente e, com esses dados, decidir, por exemplo, fazer uma promoção na hora, reagindo de imediato ao conjunto de dados que reuniu. No segmento “Voz e Escrita”, a Microsoft faz a análise sentimental ao texto, muito usado nas redes sociais, permitindo perceber se o que escrevemos é positivo ou negativo.

Em breve, o atendimento telefónico nos call centers será automatizado. Na prática, uma máquina vai perceber pelo tom de voz ou pelas palavras usadas que o cliente está furioso, optando por responder ou por passar a chamada para a “máquina” mais simpática. “Quando programamos assistentes virtuais como o Google Assistant, a Cortana do Windows, o Siri da Apple ou a Alexa da Amazon, já podemos associar-lhes uma personalidade. Conseguir pôr os assistentes a reagirem em função da emoção é o objetivo. Basta serem treinados para responderem de forma empática”, sustenta Manuel Dias.

Para Andrew McStay, professor da Universidade de Bangor, no País de Gales, e autor do livro Emotional AI: The Rise of Empathic Media, trata-se de “vigilância a 360 graus” que, a ser usada no local de trabalho, poderá ter um impacto diferente. Como vão os patrões conseguir distinguir se um funcionário está com má cara por estar furioso, ou se está apenas concentrado ou com dor de cabeça? “Nas empresas, os líderes pretendem compreender melhor as emoções das pessoas que integram as suas equipas, através daquilo que escutam e observam, para poderem comunicar e dar feedback de forma mais empática, eficaz e retirarem o melhor de cada pessoa. Um outro foco das empresas é transformar os conflitos em produtividade e promover a responsabilidade”, alerta António Sacavém.

Manuel Dias não tem dúvidas de que “Portugal precisa de acelerar na adoção destas tecnologias, todas já disponíveis. Mas este “entusiasta de dados” também avisa: “Não basta reconhecer sentimentos sem analisar o cenário à volta. As empresas têm de pensar na forma como vão usar a informação da Inteligência Artificial para alterar modelos de negócio. Só recolher a informação dos sentimentos é insuficiente.”

Aproveite a campanha Ler e Viver e receba o valor gasto na assinatura em experiências à escolha