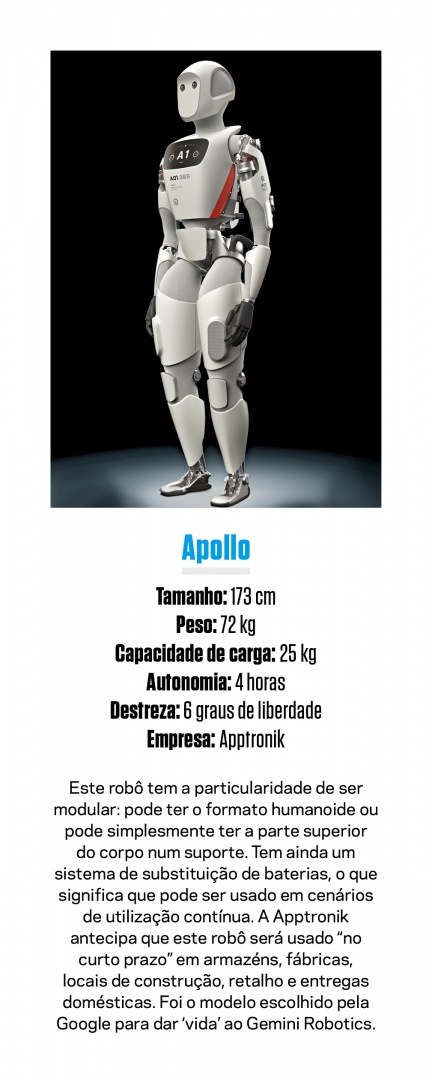

Podes colocar os frutos secos na marmita?” Devagar, mas com certeza no movimento, um robô de formato humanoide, desenvolvido pela empresa Apptronik, pega numa pequena caixa e coloca-a dentro de uma lancheira. “Podes colocar também a laranja?”. De um pequeno prato com diferentes peças de fruta, o robô volta a pegar de forma lenta, mas novamente com certeza, numa laranja, colocando-a na lancheira. Não seria bom ter um robô lá por casa que lhe preparasse a marmita todos os dias? E o ajudasse noutras tarefas rotineiras, como estender a roupa, preparar as refeições ou simplesmente manter a casa arrumada? E se além da ajuda em casa, também se estendesse ao trabalho?

O exemplo aqui descrito faz parte de um dos mais recentes vídeos de demonstração do Gemini Robotics, um modelo de Inteligência Artificial (IA) desenvolvido pela Google especificamente para robôs. Nos últimos anos, os assistentes digitais evoluíram de forma significativa graças aos desenvolvimentos dos chamados grandes modelos de linguagem (LLM), que fazem com que ferramentas como o ChatGPT, o Gemini ou o Claude percebam e escrevam texto com uma qualidade muito próxima da de um humano. Mas o que começou por ser uma interação baseada apenas em texto rapidamente evoluiu para os chamados modelos multimodais – sistemas que percebem texto, imagens, sons, vídeos, programação ou até mesmo diferentes idiomas… Estão, de certa forma, a ficar com uma inteligência mais abrangente, mais generalista.

Pelo que o salto para a robótica parecia quase inevitável – o que aconteceria se estes novos modelos de IA, com todas as suas potencialidades, fossem aplicados aos robôs? A resposta começa a ser dada e tem aparecido sob a forma de inúmeras demonstrações, de empresas diferentes – Figure, Tesla, Google e Meta – que mostram robôs a moverem-se de maneira mais natural, a realizarem tarefas mais complexas e a mostrarem um nível de mobilidade ou destreza mais aproximado do humano. Estas tecnológicas, bem como outras empresas e centros de investigação, estão a desenvolver os chamados modelos de visão-linguagem-ação (VLA na sigla em inglês), o equivalente do GPT da OpenAI, mas para robôs. E se à primeira vista pode não parecer uma transformação significativa, é uma etapa essencial no caminho para a democratização da robótica.

“Antes era difícil passar a informação para o robô, era preciso programá-lo especificamente para uma tarefa”, explica Eduardo Mendes, diretor executivo (CEO) da Connect Robotics, uma startup de drones autónomos que fazem entregas em curtas distâncias. Com os novos modelos de IA, os robôs já conseguem fazer algumas generalizações, o que significa que não é preciso instruir a máquina especificamente no manuseamento de objetos. “Os modelos de visão computacional associam o texto às imagens. Conseguem criar esta noção de que uma banana é mais provável estar na cozinha do que na casa de banho. Estes dados acabam por permitir aos robôs decifrarem coisas sobre as quais não tinham tanta certeza. Há uns anos era difícil dizermos ‘pega no copo e põe na máquina’. Máquina, mas qual a máquina? Agora percebem que é provável que seja a máquina da loiça. Com os novos modelos, conseguem perceber isso, mesmo sem ser explícito”, explica por seu lado Iolanda Leite, professora associada na divisão de robótica, perceção e aprendizagem no Instituto Real de Tecnologia KTH, na Suécia.

Se ver um robô a pegar numa banana e a colocá-la no frigorífico (e não num micro-ondas, por exemplo), parece uma demonstração de raciocínio, o CEO da Connect Robotics lembra o que está na base destes sistemas de Inteligência Artificial avançados. “Agora podemos juntar muitos e muitos dados de câmaras e fazer a análise destes dados. Assim, estatisticamente podemos comparar os dados recolhidos. É esse o diferencial. Os LLM são dados estatísticos, o ChatGPT e Gemini em vez de processarem vídeo ou áudio, estão a encontrar a correlação estatística entre as palavras”, explica.

Ou seja, aquilo que o robô faz não é mais do que encontrar uma relação estatística entre a banana, enquanto fruta, e o local mais provável da mesma numa casa. É esta combinação estatística que faz, na demonstração da Google, que o robô da Apptronik perceba o que é uma lancheira quando o utilizador lhe pede isso especificamente. Na prática, a evolução do software e da Inteligência Artificial Generativa está a resolver aqueles que eram, na visão de Eduardo Mendes, três grandes obstáculos na robótica. “O primeiro era a perceção, depois o raciocínio e por fim a atuação. Para nós [humanos] é tudo muito óbvio.

Um robô tem uma câmara que está a visualizar muitos píxeis. O problema da perceção é como transformo esse monte de píxeis em informação real para perceber o ambiente. Como sei onde começa e termina um objeto, que objeto é, a que distância está, onde termina a mesa, onde começa a banana… Já no raciocínio, qual é a ordenação da banana? O que tenho de fazer com a banana? Há muitos problemas que são de software”, detalha o brasileiro de 41 anos, natural de São Paulo, mas a viver em Vila Nova de Gaia.

Neste contexto, o executivo lembra que existe outra área em grande desenvolvimento e que está a potenciar tanto o desenvolvimento de sistemas de IA, como de robótica – os simuladores digitais. “Permitem estatisticamente executar mil milhões de vezes cada junta de cada motor, em software, para dizer que se quero chegar ao ponto X, tenho que mexer este e aquele motor. Antes tudo era feito de forma muito definida, agora com o avanço das placas gráficas e da IA posso treinar estatisticamente de forma muito rápida o que preciso de fazer”, explica. Por exemplo, a Meta criou 20 simuladores digitais nos quais tem treinado o seu modelo de IA para robótica, que depois é aplicado em robôs em contexto real.

Já para Iolanda Leite, algumas das demonstrações de robótica que têm sido feitas pelas grandes tecnológicas acabam por não ser tão surpreendentes, pois em ambiente académico ou de laboratório a realização de tarefas complexas por parte dos robôs já é uma realidade há algum tempo. “O software está mais capaz, está tudo um nível acima. Dá a sensação de que estão a evoluir muito rápido. Mas nós só vemos os melhores momentos e as edições cortadas do que está a acontecer, [as empresas] não são muito transparentes sobre, por exemplo, tudo o que não correu bem”, alerta.

O caminho das pedras da robótica

Por que razão a robótica é vista com tanto fascínio? Porque promete ser uma ajuda importante na resolução de alguns problemas inevitáveis – como a diminuição da força de trabalho e o envelhecimento da população –, ao mesmo tempo que promete trazer vantagens em termos de qualidade de vida – permitir às empresas fazer mais com menos recursos ou às pessoas libertarem-se de tarefas aborrecidas, dando-lhes mais tempo pessoal.

Mas não pense que estes avanços em IA e robótica recentes significam que vai ter um robô-assistente pessoal no curto prazo a cirandar pela casa. A área da robótica ainda tem muitos desafios por resolver. Mesmo que a questão do software (vamos imaginá-lo como o cérebro do robô) seja totalmente resolvida, o que distingue a robótica de um assistente digital no nosso computador é justamente a necessidade de existir e interagir no mundo físico. Aliás, a robótica é vista como uma materialização da IA no mundo físico.

O que significa que o ‘cérebro’ do robô até pode ser muito inteligente, mas para executar ações precisa de hardware como atuadores e controladores, precisa de câmaras para analisar uma área e objetos em tempo real, precisa de baterias para conseguir operar longe de uma tomada. “Os problemas da robótica sempre foram dois. A capacidade de inteligência e a capacidade de energia. As baterias, a forma como existem agora, duram muito pouco. E se o robô estiver ligado à tomada, não vai longe. Ou se vai carregar cargas pesadas, isso requer muita energia. Precisamos de ter novas formas de energia de forma mais condensada”, considera Eduardo Mendes sobre o problema da autonomia energética. A questão do próprio preço do hardware é, para Iolanda Leite, natural de Chaves e atualmente a viver em Estocolmo, uma área que também precisa de ser melhorada. No centro de investigação do qual faz parte, existem mais de duas dezenas de robôs diferentes, de simples braços robóticos a máquinas de formato humanoide.

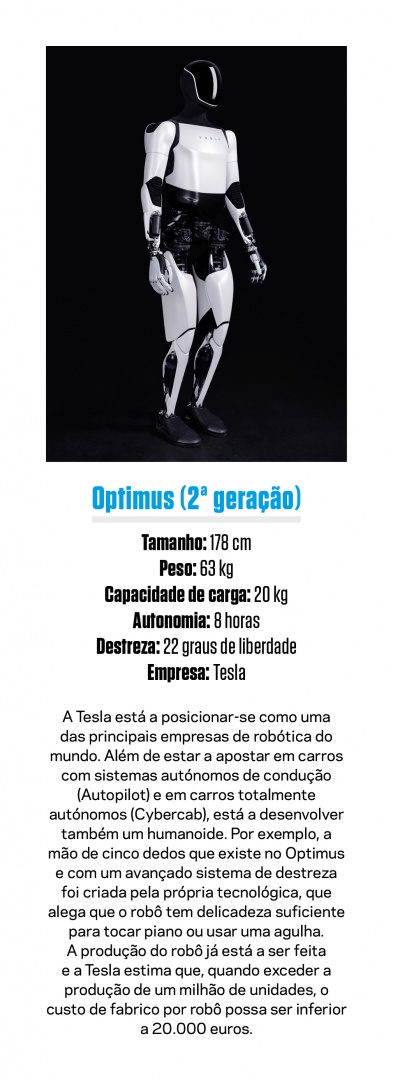

Sim, os robôs estão a ficar mais acessíveis, mas ainda não ao ponto de estarem acessíveis como outros equipamentos de eletrónica. E ainda antes de os robôs entrarem em nossa casa, há outros desafios por resolver. “Em casa há aspetos de privacidade, por exemplo. Estamos mais longe [de ter um robô] do que pode parecer dado este grande entusiasmo. Todas as outras máquinas que temos em casa não são tão proativas. Controlamos onde estão, o que estão a fazer, o que estão a ouvir. Um robô que precise de ter câmaras, há outros aspetos que tornam mais difícil toda essa integração”, lembra a investigadora de 40 anos. A simples ideia de ter um robô com dezenas de quilos a mover-se de um lado para o outro, podendo cair sobre uma criança ou um animal, é algo que precisará de novas abordagens nos próximos anos. Mas também aqui estão a ser dados passos importantes. O Figure 02, por exemplo, já ‘só’ pesa cerca de 70 quilogramas. O Optimus, da Tesla, pesa cerca de 63 quilogramas.

Há um outro grande desafio ao qual os robôs terão de saber adaptar-se – a própria estrutura do mundo. Não é à toa que muitos robôs têm um formato humanoide, sobretudo os modelos mais recentes usados pelas grandes tecnológicas. O motivo é simples – o mundo em que vivemos foi criado para humanos. E um robô para ser útil tem de conseguir adaptar-se a esse ambiente. “Se queremos um robô que ajude na cozinha, e a cozinha foi desenhada para nós, tem de conseguir abrir gavetas, pegar num talher, fechar as gavetas. (…) O problema é que tudo já está feito para os humanos operarem, é preciso adaptar o robô para isso. É uma fase de transição”, justifica Eduardo Mendes. Também Iolanda Leite considera que o fator humano acaba por trazer um elemento de complexidade ao desenvolvimento dos robôs. “Não há conjuntos de dados que simulem as pessoas ou a física dos objetos, por isso [o desenvolvimento] é capaz de estagnar um bocadinho. (…) Não temos boas simulações para o comportamento humano”, exemplifica. Pegar numa banana é uma ação, descascar a banana é outra e colocar a banana no frigorífico com pessoas na cozinha é outra completamente diferente.

Robôs em todo o lado

Quando pensamos num futuro com robôs, é fácil cair num cenário de ficção científica como o do filme Eu, Robô, no qual já existe um humanoide assistente na casa de muitas pessoas. Mas o futuro – a curto prazo, pelo menos – da ascensão das máquinas será um pouco diferente. Sim, haverá cada vez mais robôs em utilização, mas não obrigatoriamente com o formato humanoide. Um carro autónomo é, em boa verdade, um robô. Um drone de entregas também. Um quadrúpede que faz vistorias autónomas a edifícios também. Um autómato de transporte num armazém, igualmente. Ou seja, aos poucos vão começar a surgir muitas tipologias de robôs – equipamentos autónomos que executam tarefas específicas – que deverão libertar os humanos de tarefas mais rotineiras e repetitivas.

A Connect Robotics já está a operar entregas autónomas de drones todos os dias, na Fundação Champalimaud, em Lisboa, de material de farmácia para tratamento de pacientes. Ao todo, já foram feitas mais de 5000 entregas, segundo Eduardo Mendes. “Estamos a expandir, temos outros clientes já em contrato para fazer entregas, principalmente na área da saúde, mas também para distribuir peças de carro para as oficinas de mecânica. E estamos a iniciar agora uma nova área, chamada de olhos no céu [eye in the sky no original em inglês], que é inspeção de longa distância feita com drones”.

Este é apenas um exemplo de como a automação vai começar a ser aproveitada por diferentes áreas de negócio, neste caso a logística. “A robótica vem mudar tudo em áreas que são perigosas, repetitivas e em muitas coisas que podem ser e devem ser automatizadas. Por exemplo, nós não fomos feitos para conduzir. Muita gente morre todos os dias porque não somos feitos para conduzir. Daqui a 500 anos as pessoas nem vão acreditar que fazíamos uma caixa de ferro com motor de explosão”, comenta o CEO da Connect Robotics.

É justamente na inevitabilidade de uma vida com mais robôs que Iolanda Leite tem desenvolvido a sua investigação. Formada no Instituto Superior Técnico, a professora e investigadora tem trabalhado no conceito de tornar os robôs mais sociais. “Sociais não no sentido de serem os nossos melhores amigos. Mas uma vez que vão partilhar o espaço connosco, precisam de ser sociais, para não serem indelicados ou chatos. O meu aspirador robô, se eu estiver na sala, quero que ele vá aos quartos antes de vir fazer barulho para onde estou. Esta consciência social é muito importante para que depois consigam fazer aquilo para o qual estão programados”. Isto porque ao perceberem o contexto social no qual se inserem, permitirá “melhorar o serviço prestado às pessoas”. Mas a investigadora não tem dúvidas: nesta fase, “menos humanos é melhor para os robôs”, pois as pessoas trazem “mais caos” ao ambiente no qual o robô opera.

Com todos os desenvolvimentos recentes, a Inteligência Artificial começa a ganhar corpo e a ocupar um espaço que era dos humano. A ascensão das máquinas pode ser lenta, pelos motivos já apontados, mas é inevitável.