“Uma publicação num blogue que tenha 100 comentários e, desse número, apenas um deles for negativo, a qual é que nós vamos responder? Ao negativo”, começa por dizer Maria João Nogueira, Diretora de Comunicação e Relações Públicas na Fundação Portuguesa das Comunicações e especialista em redes sociais.

No geral, o ser humano reage mais ao que é negativo porque está “artilhado” em termos cerebrais para enfrentar mais rapidamente a ameaça, faz parte da sua estratégia de sobrevivência. “Aquilo que nos impacta negativamente provoca-nos maior atenção e as redes sociais jogam com isso. Portanto, sempre que existe uma indignação, um comentário negativo ou uma afirmação de ódio, de racismo, de xenofobia ou de misoginia, coisas profundamente injustas, captam-nos muito mais a atenção e provocam uma reação”, afirma Maria João Nogueira.

Sempre que se faz isso, dá-se força tanto à pessoa ou pessoas que pretendem alimentar esse ódio, porque se sentem validadas, como também ao algoritmo, porque é-lhe dada a informação de que determinado conteúdo e pessoas são relevantes ou importantes. “Os algoritmos não vêem qualidade, só quantidade. Portanto, estamos a criar uma validação”, explica a especialista.

Sempre que existe uma indignação, um comentário negativo ou uma afirmação de ódio, de racismo, de xenofobia ou de misoginia, coisas profundamente injustas, captam-nos muito mais a atenção e provocam uma reação

Para as plataformas, é vantajoso que o ódio seja lá alimentado, na medida em que elas vivem de utilização e tráfego e tudo o que gera tráfego, tal como o ódio, é benéfico. “O algoritmo, sobretudo o do Facebook, que tem um modelo de negócio mais baseado em tráfego do que o Twitter, tem tendência para mostrar às pessoas aquilo ao qual se sabe que elas vão reagir”, esclarece a especialista. Aliás, esta rede social, ao contrário do Twitter, em que pode ver-se apenas conteúdos dos utilizadores que se segue, expõe, já à partida, às pessoas publicações que não fazem parte do seu círculo de amigos online. “Na perspetiva do algoritmo, o Facebook é mais prejudicial do que o Twitter”, garante Maria João Nogueira.

Mas não são apenas estas duas redes sociais que se comportam assim. “Todas as plataformas interessam-se pelo tráfego, sendo irrelevante se ele é bom ou mau. E vão usar todas as ferramentas que forem necessárias para o incrementar”, diz.

E os “polícias” das redes sociais? “Com grandes poderes vêm grandes responsabilidades“

Seria impossível que o acompanhamento e controlo de conteúdo publicado nas redes sociais fosse feito apenas por pessoas. São publicados milhões de tweets por minuto e a tentativa de controlar o tipo de conteúdos que se publicam é, em primeiro lugar, tecnológica, ou seja, existem scripts e bots a correr as plataformas para identificar determinado tipo de conteúdo. “Hoje, se alguém fizer um tweet onde escreva, na mesma publicação, vacinas e 5G, a conta é automaticamente suspensa”, diz Maria João Nogueira.

Contudo, explica a especialista, as máquinas são altamente falíveis e os scripts que se põem a correr para proceder a este tipo de suspensões não detetam, por exemplo, ironia. “Já existem algumas coisas feitas em termos de Inteligência Artificial para ensinar as máquinas a perceber a ironia, mas ainda não a um nível que lhes permita serem funcionais. Scripts e algoritmos que controlem o discurso vão ser sempre altamente falíveis”, garante.

Encontrar um equilíbrio é o grande desafio destas plataformas, que já têm uma influência muito grande na vida das pessoas. “Tal como dizia o tio Ben, no Homem-Aranha, “com grandes poderes vêm grandes responsabilidades”. Ou seja, tem de haver uma gestão equilibrada e as plataformas têm de mostrar que estão, por um lado, a contrariar as tendências de ódio e a apagar conteúdos com discursos que são manifestamente violentos, mas vão deixar passar outros que, sendo violentos, não são manifestamente violentos”, explica a especialista.

A língua torna-se uma questão essencial, sendo que este “equilíbrio” será encontrado, em primeiro lugar, nos EUA e países anglófonos. “Até existirem ferramentas que sejam funcionais em inglês e daí até estarem refletidas no universo português vai uma distância grande”, diz. Relativamente às redes privadas, como o WhatsApp ou o Telegram, por exemplo, é muito mais difícil controlar os boatos, as fake news e a manipulação de massas, explica Maria João Nogueira.

As redes da “batatada” e as redes “fofinhas“

Ao longo dos anos, tem-se assistido, nas várias redes sociais, a “espetáculos” sociais, ideológicos e políticos, que acabam por mostrar de forma muito evidente a velocidade, o impacto e o alcance que qualquer uma delas pode ter. Muitas vezes, o resultado é negativo, mas é, outras tantas, positivo. “O problema não está nas ferramentas mas sim nas pessoas. As redes sociais são uma ferramenta e as ferramentas são aquilo que fazemos delas”, afirma a especialista, que diz faltar, também, alguma legislação e enquadramento legal.

No fim do mês passado, foi posto a circular um documento, que aparentava ser do governo, com um alegado plano de desconfinamento que se disseminou nas redes sociais com muita rapidez, e que obrigou o próprio governo a avisar que era falso. “Esta situação foi obviamente uma forma abusiva da utilização das redes sociais, que serviu apenas para desestabilizar. E é com este tipo de episódios que se cria medo nas pessoas e, consequentemente, surge a violência”, afirma a especialista.

Mas também se conseguem feitos incríveis a partir das redes sociais, diz, por outro lado. Num dos diretos do instagram de Como é Que o Bicho Mexe?, do Bruno Nogueira, por exemplo, o humorista falou sobre a falta de reservas de sangue no Instituto Português do Sangue. No dia seguinte, a fila à porta do Intituto era “enorme”. “Claro que isto aconteceu a partir de uma pessoa que já tem voz nas redes sociais, mas este pedido chegou-lhe precisamente porque o Bruno Nogueira é alguém que tem o poder de influenciar pessoas nas redes”, afirma Maria João Nogueira, que diz que, além do bom e do mau, existem momentos muito hilariantes oferecidos pelas redes sociais.

Se se deixar de dizer ao Twitter que determinado conteúdo é valioso – no sentido de criar interação e não relativamente à sua qualidade – ele deixa de apresentar esse conteúdo.

“Há uns anos, no Twitter, um espanhol pôs a circular o boato de que Portugal estava a passar por um golpe de Estado e usou a hashtag #prayforPortugal. Por cá, começámos a ver pessoas de todo o mundo a usarem essa hashtag, que ficou nas tendências, e entrámos na brincadeira. De repente, estava toda a gente a falar sobre isso e foi das noites mais divertidas que passei no Twitter”, conta a especialista.

Já o Instagram é uma rede social mais “fofinha”, brinca Maria João Nogueira, e os seus utilizadores não têm tanta disposição para, ativamente, exercerem a sua cidadania, tal como acontece no Pinterest. “Mas há redes sociais onde a batatada faz parte. O Reddit, por exemplo, é mesmo só para a batatada. Há redes sociais que se adaptam melhor do que outras e a linguagem utilizada em cada uma delas, mesmo de um só utilizador e sobre a mesma temática, é diferente, dependendo da plataforma”.

A #Fachina e o “sim e não” de se poder fintar os algoritmos

Maria João Nogueira tem um relação próxima com todas as redes sociais, porque trabalha há muitos anos nesta área, mas é no Twitter, onde tem mais de 9 mil seguidores, que partilha mais ativamente conteúdos.

Os algoritmos, não só no Twitter mas também nas outras redes, funcionam com base em conhecimento que vão adquirindo sobre aquilo que as pessoas fazem ou dizem. “Mas é possível ensinar os algoritmos, da mesma maneira que é possível a quem os produz afinar a forma como eles vão ganhando conhecimento sobre o que se passa”, diz.

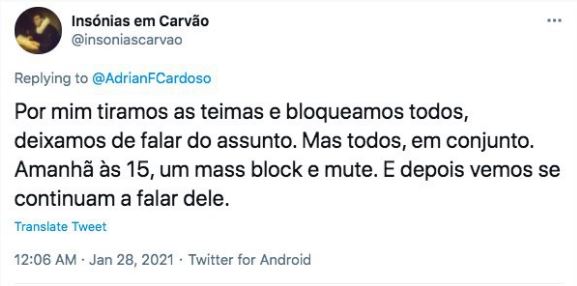

Um exemplo muito específico da tentativa de se fintar os algoritmos para se travar o ódio foi uma iniciativa que surgiu a partir de uma conversa no Twitter entre o Insónias a Carvão e outra pessoa, em que foi sugerido que, durante um mês, ninguém falasse sobre o Chega, fizesse retweets, comentasse ou respondesse a publicações e bloqueasse quem tentasse acicatar uma discussão sobre este tema. “Era uma coisa que eu já defendia há muito tempo e, por isso, entrei na onda do Insónias. Juntamente com a @a_john e o @Sir_Bronn_, inventou-se um nome, a #Fachina, e lançou-se essa ação nos últimos dias de janeiro”, conta a especialista.

Houve algum trabalho incial para se explicar aos utilizadores o que se pretendia, mas a reação e aprovação das pessoas foi quase imediata. E, um mês depois do lançamento da iniciativa, a especialista analisou o número de gostos, retweets e novos seguidores que as cinco principais contas do Chega ou relacionadas tinham tido durante o mês de janeiro, fazendo a comparação com o mês de fevereiro. “Um mês é muito pouco tempo para condicionar o algoritmo mas, mesmo assim, a diferença de números de janeiro para fevereiro foi de 30%. Um mês apenas foi suficiente para criar este impacto, ou seja, esta é uma forma de condicionar o algoritmo pela positiva”, explica Maria João Nogueira.

Se se deixar de dizer ao Twitter que determinado conteúdo é valioso – no sentido de criar interação e não relativamente à sua qualidade – ele deixa de apresentar esse conteúdo. “Muitas pessoas disseram que isto é uma forma de ignorar o problema, mas o que fizemos foi precisamente o contrário. Continuamos a lutar contra os ideais do Chega e contra as posições racistas e xenófobas que toma, apenas não lhes damos visibilidade. Porque, nas redes sociais, alimentar estas discussões só favorece a mensagem de quem toma posições deste género”, conclui a especialista.