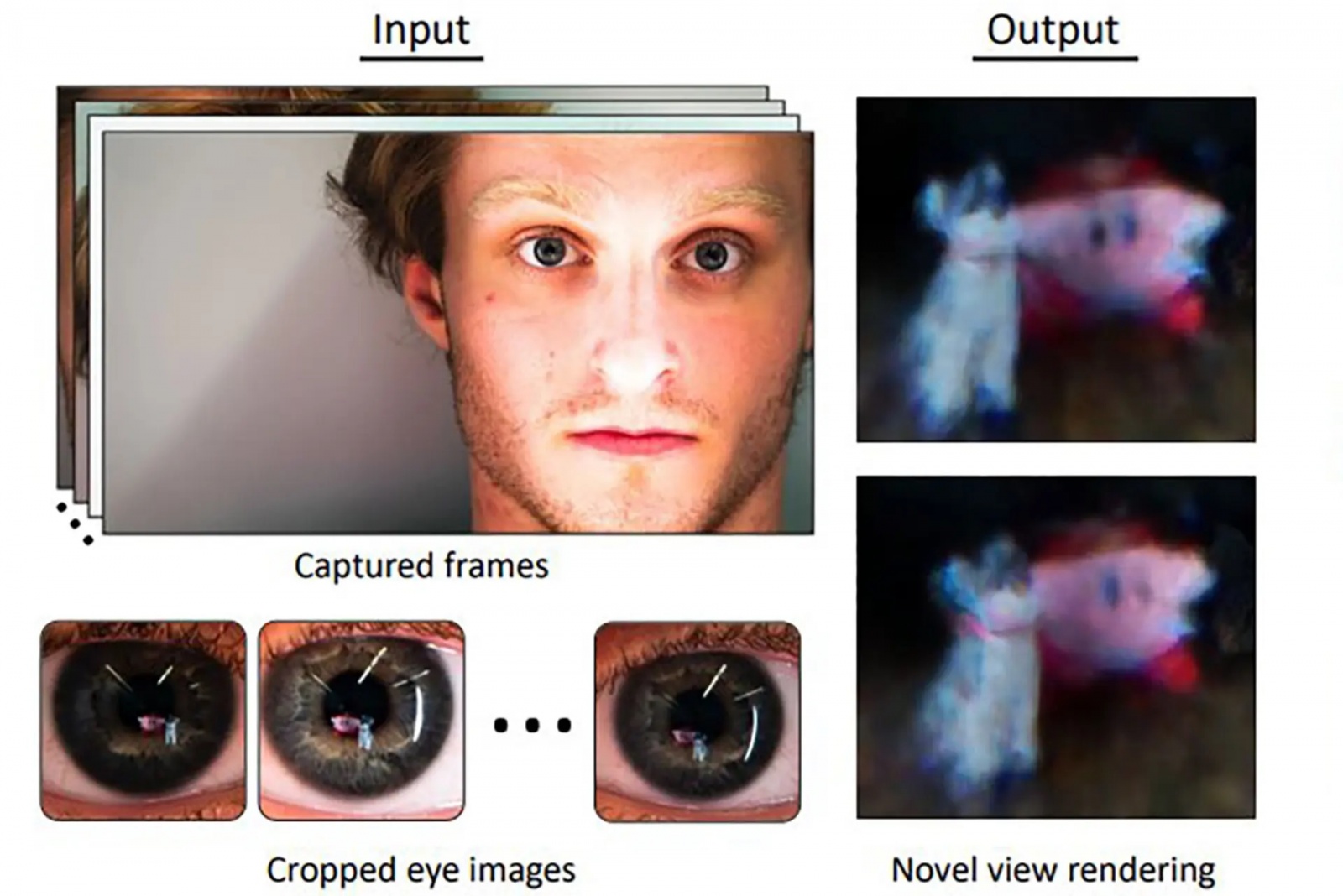

Um estudo publicado no repositório de trabalhos científicos arXiv por investigadores da Universidade de Maryland, nos EUA, revela que é possível usar tecnologia NeRF (acrónimo de neural radiance fields, que usa redes neuronais para identificar pontos em comum entre elementos das fotografias, calcular a distância aproximada entre eles e daí gerar um modelo tridimensional) para, a partir de múltiplas imagens de alta definição de uma pessoa a mover-se numa sala, fazer zoom nas suas córneas e obter o esboço dos contornos dessa divisão ou de objetos e pessoas que estejam à sua frente.

O tratamento passa por virar as imagens, remover efeitos de cor e detalhe que sejam adicionados pela íris do utilizador, remover a distorção de espelho curvo e só depois as imagens ficam prontas para serem usadas. Os modelos tridimensionais obtidos desta forma ainda não são propriamente realistas, nem têm grande resolução, mas o estudo serve para demonstrar já as capacidades que a tecnologia NeRF poderá trazer no futuro, adianta a publicação New Atlas.

Um cenário de utilização real testado pela equipa passou por fazer zoom nos olhos das cantoras Miley Cyrus e Lady Gaga em alguns videoclipes, esperando tirar partido da elevada qualidade de imagem e condições de luz favorável para identificar os elementos que estavam à sua frente. Mas os resultados ainda não foram os esperados: Lagy Gaga parecia estar a olhar para o que se assemelha a um tronco de uma pessoa e Miley Cyrus estava a olhar, provavelmente, para uma grelha de iluminação.

De recordar que a tecnologia NeRF já está a ser usada por várias empresas como forma de criar modelos tridimensionais a partir de meras imagens: a Google está a usar o sistema para criar uma representação 3D de alta fidelidade do interior de espaços públicos; enquanto a Nvidia está a usar a técnica para conseguir converter texto em imagens tridimensionais.

Leia o estudo completo da Universidade de Maryland aqui.